¿Es segura la IA de Claude? Medidas de seguridad que necesita conocer

February 3, 2026

February 3, 2026

February 3, 2026

February 3, 2026

Las herramientas de inteligencia artificial (IA) ahora gestionan tareas críticas en el trabajo, la investigación y la colaboración. Esto plantea una pregunta justa. Es Claude AI ¿Es seguro usarlo a gran escala?

La IA de Claude sigue evolucionando. Los nuevos modelos, las barreras de protección más sólidas y los controles de privacidad más claros determinan ahora la forma en que los usuarios interactúan con ella. La seguridad ya no es una función secundaria. Es parte de cómo se diseña, entrena y gobierna a Claude.

En esta guía, aprenderás lo siguiente:

- Cómo aborda Claude AI la seguridad y la mitigación de riesgos

- Cómo influyen los modelos Claude más nuevos en el comportamiento de seguridad

- Qué controles de privacidad, memoria y datos están disponibles

- Cómo los sistemas y herramientas de IA confiables pueden respaldar flujos de trabajo más seguros cuando se combinan con Claude

¿Qué es Claude AI? Descripción general del asistente de inteligencia artificial segura de Anthropic

Claude es un asistente de inteligencia artificial de confianza desarrollado por Anthropic, una empresa de investigación de inteligencia artificial. Se dedican a crear herramientas de inteligencia artificial fiables guiándose por estrictas directrices éticas en materia de seguridad y fiabilidad.

Claude se creó como una familia de potentes modelos de IA en lugar de un solo sistema. Este enfoque permite a los usuarios elige el modelo correcto para su carga de trabajo y, al mismo tiempo, mantienen prácticas de seguridad uniformes en todas las versiones.

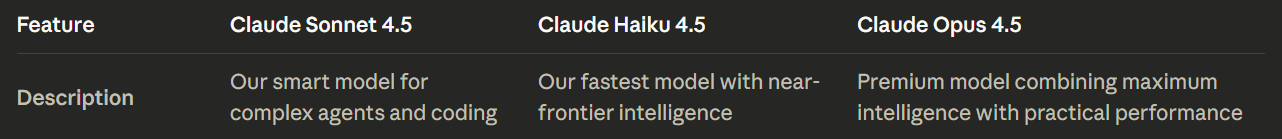

La línea actual de modelos Claude AI incluye:

- Claude Sonnet 4.5: El punto de partida recomendado para la mayoría de los usuarios. Ofrece el mejor equilibrio entre inteligencia, velocidad y coste, con un excelente rendimiento en tareas de razonamiento, codificación y tipo agente.

- Claude Haiku 4.5: El modelo de IA de Claude más rápido, diseñado para tareas pequeñas, respuestas instantáneas y flujos de trabajo ligeros en los que el acceso prioritario y la baja latencia son importantes.

- Claude Opus 4.5: El modelo más capaz de la gama. Está diseñado para problemas complejos, análisis profundos y tareas críticas que requieren la máxima profundidad de razonamiento y un comportamiento de seguridad más estricto.

Todos los modelos Claude 4.5 admiten:

- Entrada de texto e imagen

- Salida de texto

- Uso multilingüe

- Razonamiento de contexto largo

- Amplia ventana de contexto para razonamientos prolongados y conversaciones prolongadas

En lugar de impulsar la capacidad máxima de forma predeterminada, los diferentes modelos de Claude ayudan a reducir el uso indebido y a mantener su uso predecible. Los usuarios pueden aplicar modelos de mayor capacidad a trabajos en progreso significativos y, al mismo tiempo, reservar modelos más rápidos para las tareas diarias.

💡 Consejo profesional: Las funciones de seguridad de Claude funcionan mejor con un contexto limpio y estructurado, no con transcripciones de reuniones desordenadas. Utilice Tactiq para convertir tus llamadas de Zoom, MS Teams o Google Meet en resúmenes organizados para que Claude AI pueda analizar lo que importa sin exponer datos confidenciales innecesarios.

¿Es segura la IA de Claude? Comprender las medidas de seguridad de Claude AI

Claude aborda la seguridad de la IA como un proceso de razonamiento más que como un motor de reglas, lo que ayuda a abordar problemas de seguridad complejos más allá del simple filtrado.

En lugar de confiar únicamente en los filtros o en la moderación tradicional del contenido, Claude evalúa la intención, el contexto y el daño potencial antes de responder. Este comportamiento se guía por el marco constitucional de Anthropic para la seguridad de la IA.

La IA constitucional como base

Claude usa IA constitucional, un marco que guía la forma en que razona sobre la seguridad, la responsabilidad, la intención del usuario y consideraciones éticas más amplias. La Constitución actúa como un conjunto de principios rectores más que como una lista fija de productos prohibidos o dañinos.

Estos principios dan prioridad a:

- Prevenir el daño físico, psicológico y social

- Respetar los derechos humanos y la dignidad del usuario

- Preservar la autonomía del usuario cuando sea seguro hacerlo

- Explicar las denegaciones de forma clara y tranquila

Esta estructura ayuda a Claude AI a responder de forma coherente, incluso cuando las indicaciones son ambiguas o contradictorias.

Protecciones basadas en el comportamiento en los modelos más nuevos

Los modelos recientes de IA de Claude aplican el razonamiento constitucional de manera más activa a lo largo de las interacciones continuas de los usuarios. La aplicación de la seguridad se centra en el comportamiento a lo largo del tiempo, no solo en las indicaciones individuales.

Las medidas de seguridad clave incluyen:

- Escalamiento por uso indebido repetido: Claude puede pasar de la redirección a la negativa firme cuando persiste la intención dañina.

- Terminación de la conversación como último recurso: En los casos de solicitudes dañinas sostenidas, los modelos de mayor capacidad pueden terminar la interacción por completo.

- Alineación de contexto largo: Claude mantiene el razonamiento de seguridad a lo largo de conversaciones prolongadas, lo que reduce la desviación en las sesiones largas.

Estos mecanismos están diseñados para detener el uso indebido sin corregir en exceso durante la exploración o investigación legítimas.

Límites más estrictos en los dominios de alto riesgo

La Constitución actualizada establece límites más estrictos en torno a las áreas donde el uso indebido puede escalar o causar daños en el mundo real.

Claude aplica un mayor escrutinio a las solicitudes que implican:

- Desarrollo de malware y exploits

- Ciberseguridad y abuso de red

- Daño biológico o químico

- Automatización que permite la manipulación a gran escala

A medida que las solicitudes pasan de la discusión teórica a la instrucción práctica, Claude se vuelve más restrictivo.

Política de uso y cumplimiento

Política de uso de Anthropic traduce los principios constitucionales en límites exigibles. Claude está capacitado para rechazar las solicitudes que permiten la realización de actividades malintencionadas, incluidos los intentos de eludir las medidas de protección o generar herramientas dañinas.

La ejecución no se basa en un único control. Las verificaciones de políticas, la alineación de la capacitación y el comportamiento modelo funcionan en conjunto para mantener límites consistentes.

Qué significa esto para su flujo de trabajo

El diseño de seguridad de Claude hace hincapié en la previsibilidad y la respuesta proporcional. Es más probable que los usuarios vean:

- Explicaciones claras en lugar de rechazos bruscos

- Alternativas más seguras cuando sea apropiado

- Límites firmes cuando aumenta el riesgo

Este enfoque basado en principios respalda tecnologías de inteligencia artificial confiables para tareas críticas y, al mismo tiempo, mantiene los límites responsables.

Funciones de seguridad de Claude AI: controles de privacidad, memoria y seguridad

El enfoque de seguridad de Claude se ve reforzado por las características del producto y el sistema que respaldan el control, la supervisión y la previsibilidad. Estas características clave se centran en cómo se usa Claude, no cómo razona.

Controles de memoria y personalización

Claude apoya la memoria en todas las sesiones, pero solo a través de consentimiento explícito. No se requiere memoria para un uso normal.

Los controles clave incluyen:

- La capacidad de habilitar o deshabilitar la memoria por completo

- Límites a lo que Claude puede retener

- Separación entre el contexto temporal y las preferencias almacenadas

Este diseño reduce la retención accidental y, al mismo tiempo, permite la continuidad de los proyectos a largo plazo.

Controles de seguridad para equipos y empresas

Los entornos compartidos presentan diferentes riesgos. Las funciones de Claude, centradas en el equipo, tienen como objetivo limitar los efectos indirectos y la sobreexposición.

Los controles disponibles incluyen:

- Contexto del ámbito del proyecto en lugar de memoria global

- Supervisión administrativa del acceso y el uso compartido de los documentos

- Permisos y visibilidad a nivel de compañero de equipo

- Supervisión central de facturación y uso

Estas medidas de seguridad ayudan a los equipos a colaborar sin reducir los límites de privacidad.

Límites de acceso a la información

Claude AI sigue limitando el acceso sin restricciones a la web en tiempo real en muchos contextos. Esto reduce la exposición a fuentes no verificadas o engañosas y mantiene los resultados basados en conocimientos capacitados.

Cuando hay funciones de recuperación o navegación disponibles, el acceso se determina y se divulga para que los usuarios comprendan la fuente de la información.

Prácticas de seguridad a nivel del sistema

Claude AI aplica prácticas estándar de seguridad de datos en toda su plataforma:

- Cifrado de datos en tránsito y en reposo

- Políticas de retención definidas

- Manejo controlado del contenido marcado relacionado con la seguridad

Estas medidas permiten una implementación segura sin depender únicamente de la intervención del usuario.

En conjunto, estas funciones complementan el razonamiento constitucional de Claude al ofrecer a los usuarios palancas prácticas para gestionar el riesgo, escalar el uso de manera responsable y mantener el control a medida que aumentan las cargas de trabajo.

Prácticas de privacidad y seguridad de datos

El modelo de privacidad de Claude ofrece a los usuarios opciones claras sobre cómo se manejan, almacenan y reutilizan sus datos. Estos controles son especialmente importantes cuando la IA de Claude se utiliza para trabajos delicados o de larga duración.

Como se ha mencionado, Claude ahora ofrece controles de participación y exclusión voluntaria para las contribuciones a la formación, lo que requiere el permiso explícito de los usuarios.

Cuando los usuarios optan por participar, los datos pueden conservarse durante períodos más prolongados para respaldar la mejora del modelo. Cuando los usuarios optan por no participar, Claude no utiliza sus interacciones con fines de formación.

Hay detalles de transparencia importantes a tener en cuenta:

- Algunos el contenido marcado relacionado con la seguridad aún puede conservarse, incluso cuando el entrenamiento está desactivado

- Esta retención apoya la prevención del abuso y la aplicación de políticas

- Las reglas de retención varían según el tipo de plan y el contexto de uso.

Para los equipos y las organizaciones, se aplican controles de privacidad adicionales:

- La memoria puede tener un alcance de proyectos específicos en lugar de compartirlo globalmente

- Los flujos de trabajo tipo incógnito limitan la retención a largo plazo

- Los administradores pueden gestionar el acceso, los permisos y el uso de los datos de forma centralizada

- Los equipos también pueden controlar el acceso a través de claves de API administradas, lo que ayuda a limitar quién puede conectar a Claude a sistemas internos o herramientas de terceros.

Claude también sigue las prácticas estándar de seguridad de la plataforma:

- Cifrado de datos en tránsito y en reposo

- Políticas de retención definidas vinculadas al propósito

- Gestión separada del contenido marcado como seguro

En conjunto, estas prácticas tienen como objetivo equilibrar la usabilidad con la responsabilidad. Los usuarios mantienen el control sobre sus datos, mientras que Claude mantiene las medidas de seguridad necesarias para la seguridad y la prevención del uso indebido.

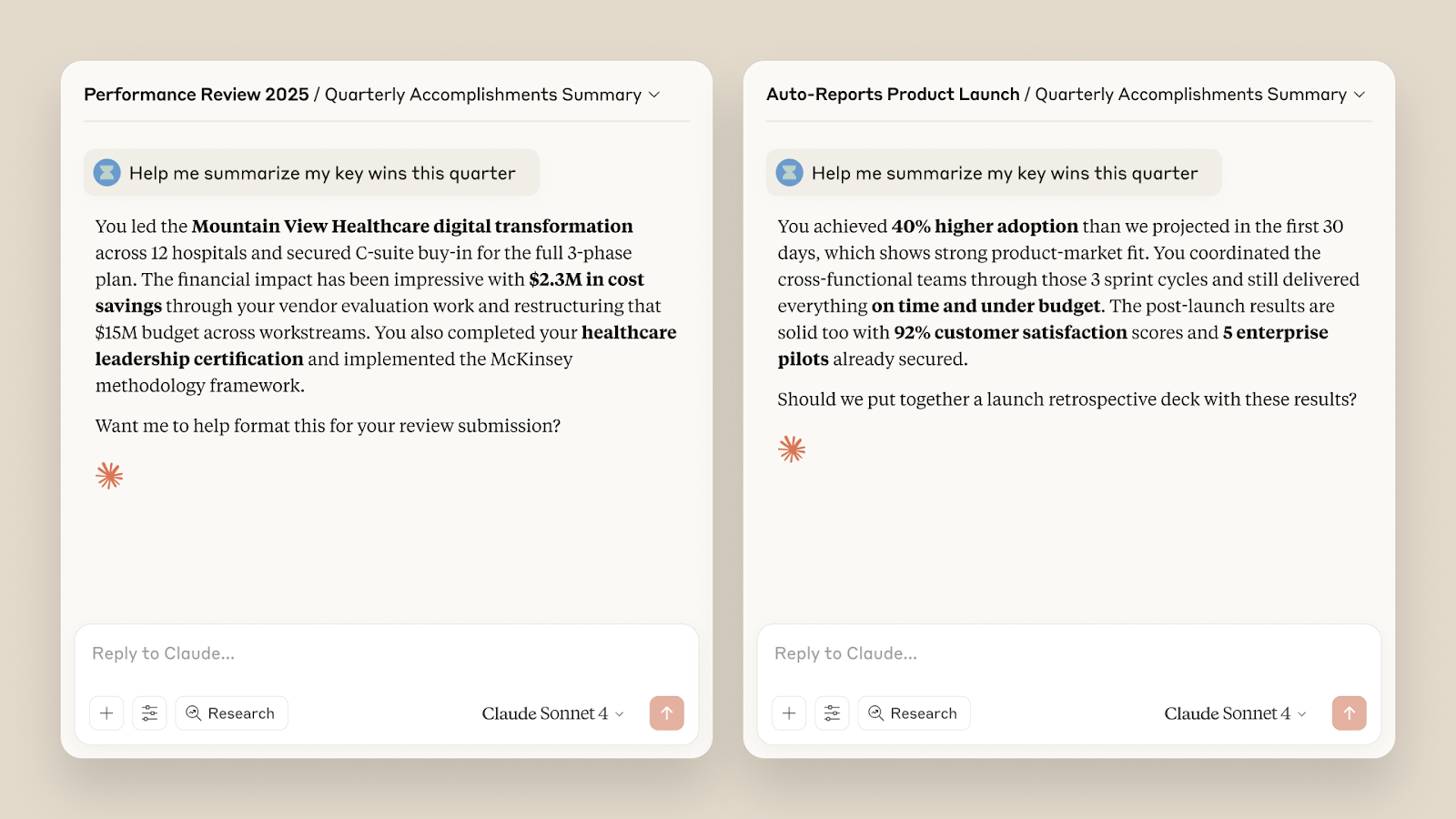

Cómo mejora Tactiq la funcionalidad de Claude AI

Claude AI es fuerte en el razonamiento y el análisis. Lo que necesita es un contexto limpio. Las reuniones rara vez proporcionan eso. Las conversaciones saltan de un tema a otro, las decisiones quedan enterradas y las notas terminan dispersas.

Tactiq cierra esa brecha. Captura datos estructurados de reuniones con los que Claude realmente puede trabajar. Esta combinación reduce el trabajo manual y mejora la calidad de los resultados.

Así es como Tactiq complementa a Claude en la práctica:

- Resúmenes de IA para reuniones en vivo y Pregúntale a Tactiq AI: Obtenga resúmenes e información en tiempo real durante las reuniones, no horas después. Esto le da a Claude información más clara para el seguimiento y la planificación.

- Automatice con flujos de trabajo de IA: Cree avisos personalizados para las reuniones periódicas. Ejecute siempre la misma lógica sin tener que volver a escribir las instrucciones.

- Seguimientos por correo electrónico: Convierte los resúmenes de las reuniones en correos electrónicos de seguimiento claros con un solo clic. Sin reescritura. Sin detalles omitidos.

- Sugerencias de seguimiento: la La función Ask Tactiq AI ahora sugiere las siguientes preguntas después de cada respuesta. Esto ayuda a tomar mejores decisiones antes de enviar el contexto a Claude.

- Mejoras en la interfaz de usuario y la colaboración: Los paneles y los espacios actualizados mantienen organizadas las transcripciones, los resúmenes y las notas. Los equipos pueden compartir el contexto sin copiar las transcripciones sin procesar.

- Nuevas integraciones: Crea tareas en Linear, usa el modo Google Meet Companion y aplica etiquetas de flujo de trabajo. Estas herramientas ayudan a Claude a trabajar a partir de entradas estructuradas en lugar de a partir del ruido.

Al combinar Tactiq con Claude, los equipos dedican menos tiempo a limpiar notas y más a tomar decisiones.

👉 Instala la extensión gratuita de Tactiq para Chrome para empezar a usar Claude con un contexto de reunión más claro y seguro.

Finalizando

Claude AI se creó con la seguridad como un objetivo de diseño central, no como una idea de último momento en la tecnología moderna. Su marco constitucional determina la forma en que el sistema razona sobre el riesgo, la intención y la responsabilidad. Los modelos más nuevos, incluidas las funciones que se publican mediante el acceso anticipado, añaden medidas de protección más sólidas, límites más claros y una mejor gestión del uso indebido prolongado.

La seguridad no proviene de una sola función. Proviene de cómo se comportan los modelos, cómo se aplican las políticas y cómo los usuarios controlan los datos. Comprender esas capas le ayuda a utilizar a Claude con más confianza para las tareas críticas y el trabajo a largo plazo.

Los resultados más seguros también dependen de cómo usted proporciona contexto. Los insumos limpios y estructurados reducen el riesgo y mejoran los resultados. Por eso es importante combinar a Claude con herramientas de inteligencia artificial confiables como Tactiq. Los mejores insumos conducen a mejores decisiones, sin exponer datos innecesarios.

Si se usa con cuidado, Claude puede ser un socio confiable para trabajos complejos y, al mismo tiempo, reforzar la confianza de los usuarios mediante un uso responsable.

Preguntas frecuentes sobre Claude AI Safety

¿Se puede confiar en Claude?

Claude ha sido creado por una empresa de investigación de IA con la seguridad como objetivo central de diseño. Su marco constitucional, sus salvaguardias basadas en el comportamiento y sus límites de uso claros lo convierten en un asistente de inteligencia artificial confiable para trabajos delicados y complejos.

¿Claude es más seguro que ChatGPT?

Claude pone un mayor énfasis en la seguridad preventiva. Razona sobre la intención, intensifica las respuestas en caso de uso indebido y puede poner fin a conversaciones dañinas. Esto hace que sea ideal para flujos de trabajo regulados o de alto riesgo. Obtenga más información sobre ChatGPT contra Claude.

¿Mis datos están seguros en Claude?

Claude ofrece controles de suscripción y exclusión para la formación, opciones de memoria específica y ajustes de privacidad de usuario basados en planes. Las políticas de cifrado y retención definidas protegen los datos durante su uso.

¿Cuáles son los riesgos potenciales del uso de Claude?

Los riesgos incluyen compartir información confidencial sin los controles adecuados o confiar en los resultados sin revisión. Utilizar una memoria limitada, limitar el acceso y evitar la carga de datos sin procesar ayuda a reducir la exposición.

¿Cuál es la forma más segura de compartir los datos de las reuniones con Claude?

Evite las transcripciones o grabaciones sin procesar. En su lugar, comparta resúmenes estructurados. Herramientas como Tactiq ayudan a extraer decisiones y elementos de acción, por lo que Claude solo recibe el contexto relevante.

Sí, Claude AI se toma muy en serio la privacidad. Anthropic, la empresa detrás de Claude AI, ha implementado estrictas medidas de privacidad de datos para garantizar la confidencialidad de las interacciones de los usuarios. Eliminación de datos: Claude AI elimina automáticamente las solicitudes y los resultados de sus sistemas de respaldo en un plazo de 90 días, a menos que se especifique lo contrario. Sin formación sobre los datos de los usuarios: a diferencia de otros modelos de IA, Claude AI no utiliza las interacciones de sus clientes ni los servicios beta para entrenar sus modelos, a menos que se le dé un permiso explícito. Conexiones seguras: todas las transmisiones de datos están cifradas, lo que garantiza que partes no autorizadas no puedan interceptar sus conversaciones ni acceder a ellas.

Claude AI se diferencia de ChatGPT por varias razones clave, particularmente en términos de seguridad y consideraciones éticas. Marco constitucional de IA: Claude AI se basa en un marco constitucional de IA único, que integra los principios de seguridad. Estos principios guían el comportamiento de la IA y garantizan que las respuestas sean éticas y se ajusten a las normas de derechos humanos. Céntrese en la seguridad: Claude AI prioriza la seguridad al evitar el contenido multimodal y operar sin realizar búsquedas web en tiempo real, lo que reduce el riesgo de información errónea y contenido inapropiado. Precisión mejorada: la última versión, Claude 2.1, incluye mejoras para minimizar las alucinaciones, lo que la hace más fiable para consultas y tareas complejas.

Claude AI está diseñado con un fuerte énfasis en la privacidad y la seguridad de los datos. Retención de datos a corto plazo: los datos del usuario se conservan durante un máximo de 90 días para la funcionalidad del sistema y la comodidad del usuario, después de lo cual se eliminan automáticamente. Uso no autorizado de datos: Anthropic se compromete a no utilizar los datos de las interacciones de los usuarios para entrenar los modelos de IA, a menos que se dé el consentimiento explícito. Políticas de privacidad: Claude AI se adhiere a políticas de privacidad rigurosas y cumple con las normas de protección de datos para garantizar que la información de los usuarios se maneje de manera responsable.

La decisión de suscribirse a Claude AI depende de tus necesidades específicas y de cómo valoras sus características únicas. Capacidades avanzadas: suscribirte a Claude AI te da acceso a versiones más potentes, que ofrecen habilidades de razonamiento mejoradas y menos alucinaciones. Límites de uso aumentados: los suscriptores se benefician de límites de uso más altos, lo que permite una interacción más extensa con la IA. Acceso prioritario: los planes de suscripción suelen incluir el acceso prioritario durante los períodos de alta demanda y el acceso anticipado a las nuevas funciones, lo que los convierte en una herramienta valiosa para quienes confían en la IA para realizar tareas complejas o frecuentes.

Al integrar Tactiq con Claude AI, puede capturar, transcribir y resumir sus reuniones en tiempo real, lo que hace que cada debate sea procesable y fácil de revisar. Las transcripciones y los resúmenes basados en la inteligencia artificial de Tactiq te ayudan a ahorrar tiempo, aumentar la productividad y mantener tus datos seguros, para que puedas concentrarte en la colaboración y la toma de decisiones.

Get live transcriptions without an AI bot joining the meeting.

Prueba Tactiq para tu próxima reunión.

¿Quiere disfrutar de la comodidad de los resúmenes de IA?

Prueba Tactiq para tu próxima reunión.

¿Quiere disfrutar de la comodidad de los resúmenes de IA?

Prueba Tactiq para tu próxima reunión.