クロード・アイは安全ですか?知っておくべきセキュリティ対策

February 20, 2025

February 20, 2025

February 3, 2026

February 3, 2026

現在、人工知能 (AI) ツールは、作業、研究、コラボレーションにおける重要なタスクを処理しています。これにはもっともな疑問が浮かびます。は クロード AI 大規模に使用しても安全ですか?

クロードAIは進化し続けています。新しいモデル、より強力なガードレール、より明確なプライバシーコントロールにより、ユーザーの操作方法が形作られるようになりました。安全性はもはや背景にある機能ではありません。クロードの設計、訓練、統制の仕方の一部でもあります。

このガイドでは、次のことを学びます。

- Claude AI が安全とリスク軽減にどのように取り組むか

- 新しいクロードモデルが安全行動に与える影響

- プライバシー、メモリ、データコントロールにはどのようなものがありますか

- Claude とペアを組むことで、信頼性の高い AI システムやツールがいかに安全なワークフローをサポートできるか

クロード・アイって何?AnthropicのセーフAIアシスタントの概要

クロードは、AI リサーチ企業の Anthropic が開発した信頼できる AI アシスタントです。安全性と信頼性に関する厳格な倫理ガイドラインに導かれた、信頼できる AI ツールの構築に専念しています。

Claude は 1 つのシステムではなく、強力な AI モデルのファミリーとして構築されています。このアプローチにより、ユーザーは次のことが可能になります。 適切なモデルを選択してください すべてのバージョンで一貫したセキュリティプラクティスを維持しながら、ワークロードに対応します。

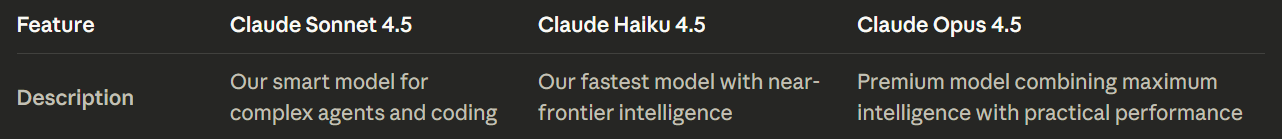

現在のClaude AIモデルのラインナップには以下が含まれます。

- クロード・ソネット 4.5: ほとんどのユーザーにおすすめの出発点です。インテリジェンス、スピード、コストのバランスが最適で、推論、コーディング、エージェントスタイルのタスクにおいて優れたパフォーマンスを発揮します。

- クロード・ハイク 4.5: 最速のClaude AIモデルで、優先アクセスと低レイテンシーが重要な小さなタスク、即時回答、軽量ワークフロー向けに設計されています。

- クロード・オーパス 4.5: ラインナップの中で最も有能なモデル。複雑な問題、詳細な分析、および最大限の推論とより厳格な安全行動が求められる重要なタスク向けに設計されています。

すべてのClaude 4.5モデルは以下をサポートしています。

- テキストと画像の入力

- テキスト出力

- 多言語での使用

- 長期的背景に基づく推論

- 長い形式の推論や長時間の会話のための大きなコンテキストウィンドウ

Claude のさまざまなモデルは、デフォルトで機能を最大化するのではなく、誤用を減らし、使用量を予測可能な状態に保つのに役立ちます。ユーザーは、処理速度が速いモデルを日常のタスク用に確保しつつ、進行の激しい作業には大容量のモデルを適用できます。

💡 プロのヒント: Claudeの安全機能は、面倒な会議の記録ではなく、わかりやすく構造化されたコンテキストで最適に機能します。使ってください。 タクティク Zoom、MS Teams、Google Meetの通話を整理された要約に変えて、Claude AIが不必要な機密データを公開することなく重要なことを分析できるようにします。

クロード・アイは安全ですか? クロード・アイの安全対策を理解する

クロードは、AIセキュリティをルールエンジンではなく推論プロセスとして捉え、単純なフィルタリングを超えた複雑なセキュリティ問題への対処を支援しています。

クロードは、フィルターや従来のコンテンツ管理だけに頼るのではなく、意図、背景、潜在的な危害を評価してから対応します。この行動は、AI の安全性に関するAnthropicの憲法上の枠組みに基づいています。

基盤としての憲法上のAI

クロードは使う 憲法上の人工知能は、安全性、責任、ユーザーの意図、およびより広範な倫理的考慮事項についてどのように推論するかを導くフレームワークです。憲法は、禁止または有害な産物の固定リストというよりは、一連の指針となる原則の役割を果たしています。

これらの原則は以下を優先します。

- 身体的、心理的、社会的危害の防止

- 人権とユーザーの尊厳の尊重

- 安全な場所でのユーザーの自律性の維持

- 拒否を明確かつ冷静に説明する

この構造により、プロンプトがあいまいだったり、敵対的だったりした場合でも、Claude AI は一貫して応答できます。

新しいモデルにおける行動に基づくセーフガード

最近のClaude AIモデルは、継続的なユーザーインタラクションを通じて、憲法上の推論をより積極的に適用しています。安全対策は、個々のプロンプトだけでなく、時間の経過に伴う行動にも重点を置いています。

主な保護措置には以下が含まれます。

- 繰り返し悪用された場合のエスカレーション: クロードは、有害な意図が続くと、リダイレクトから断固拒否へと移行するかもしれません。

- 最後の手段としての会話の終了: 有害なリクエストが続く場合、より高性能なモデルを使用すれば、やりとりを完全に終わらせることができます。

- ロングコンテキスト・アライメント: クロードは、長時間の会話でも安全に関する推論を続け、長時間のセッションでもドリフトを減らします。

これらのメカニズムは、合法的な調査や調査中に過剰に修正することなく、誤用を防ぐように設計されています。

リスクの高いドメインでの制限の強化

改定された憲法では、誤用が拡大したり現実社会に危害を加えたりする可能性のある領域には、より厳しい境界が設けられています。

クロードは、以下を含む要求に対して厳重な調査を行います。

- マルウェアとエクスプロイトの開発

- サイバーセキュリティとネットワーク悪用

- 生物学的または化学的危害

- 大規模な操作を可能にする自動化

要求が理論的な議論から実行可能な指示に移るにつれて、クロードはより制限的になります。

利用ポリシーと施行

アンソロピックの使用ポリシー 憲法の原則を強制力のある制限に変換します。クロードは、セーフガードを回避しようとしたり、有害なツールを作成したりする試みなど、悪意のある行為を可能にする要求を拒否するように訓練されています。

執行は単一の統制に依存しません。ポリシーチェック、トレーニング調整、モデル行動が連携して、境界線の一貫性が保たれます。

これがワークフローにどのような意味を持つのか

クロードの安全設計は、予測可能性と比例対応に重点を置いています。ユーザーの目に留まる傾向は、次のとおりです。

- 突然の拒否ではなく明確な説明

- 適切な場合はより安全な代替手段

- リスクが高まる場合の確固たる境界線

この原則主導型のアプローチは、責任ある制限を維持しながら、重要なタスクのための信頼できるAIテクノロジーをサポートします。

Claude AI 安全機能:プライバシー、メモリ、およびセキュリティコントロール

クロードの安全アプローチは、制御、監視、予測可能性をサポートする製品とシステムの機能によって強化されています。これらの主な機能は次のことに重点を置いています。 クロードの使い方理由は分からないけど

メモリとパーソナライゼーションの制御

Claude はセッション間でメモリをサポートしますが、セッションを通してのみサポートします。 明示的なオプトイン。通常の使用にはメモリは必要ありません。

主なコントロールには以下が含まれます。

- メモリを完全に有効または無効にする機能

- クロードが保持できるものの限界

- テンポラリコンテキストと保存されているプリファレンスの分離

この設計により、長期プロジェクトの継続性を維持しながら、偶発的なリテンションを減らすことができます。

チームと企業の安全管理

共有環境にはさまざまなリスクが伴います。Claude のチーム重視の機能は、波及効果や過度な露出を制限することを目的としています。

使用可能なコントロールには以下が含まれます。

- グローバルメモリではなくプロジェクトスコープのコンテキスト

- ドキュメントへのアクセスと共有に関する管理者による監視

- チームメイトレベルの権限と可視性

- 請求と使用状況の一元監視

これらの保護手段は、プライバシーの境界を狭めることなくチームが共同作業を行うのに役立ちます。

情報アクセス境界

Claude AIは、さまざまな状況で無制限のリアルタイムWebアクセスを制限し続けています。これにより、未検証のソースや誤解を招くようなソースにさらされる機会が減り、トレーニングされた知識に基づいたアウトプットが保たれます。

検索機能や閲覧機能が利用できる場合は、ユーザーが情報源を理解できるようにアクセスの範囲を限定して開示します。

システムレベルでのセキュリティ慣行

Claude AI は、プラットフォーム全体に標準的なデータセキュリティプラクティスを適用しています。

- 転送中および保存中のデータの暗号化

- リテンションポリシーの定義

- フラグが立てられた安全関連コンテンツの管理された取り扱い

これらの対策により、ユーザーの介入だけに頼ることなく安全に導入できます。

これらの機能を組み合わせることで、ユーザーがリスクを管理し、責任を持って使用量を拡大し、ワークロードが増大しても制御を維持するための実用的な手段がユーザーに提供され、クロードの憲法上の推論が補完されます。

データプライバシーとセキュリティ慣行

クロードのプライバシーモデルでは、ユーザーはデータの取り扱い、保存、再利用の方法を明確に選択できます。これらの制御は、Claude AI を機密性の高い作業や長期にわたる作業に使用する場合に特に重要です。

前述のように、クロードは現在、トレーニング投稿のオプトインとオプトアウトのコントロールを提供しており、ユーザーからの明示的な許可が必要です。

ユーザーがオプトインすると、モデルの改善に役立つように、データが長期間保持されることがあります。ユーザーがオプトアウトしても、Claude はユーザーのインタラクションをトレーニングに使用しません。

注意すべき透明性に関する重要な詳細は次のとおりです。

- 一部 フラグが付けられた安全関連コンテンツは引き続き保存される場合があります、トレーニングが無効になっている場合でも

- このリテンションは、不正行為の防止とポリシーの適用に役立ちます。

- リテンションルールは、プランの種類と使用状況によって異なります

チームや組織には、追加のプライバシー管理が適用されます。

- メモリのスコープは以下のように設定できます 特定のプロジェクト グローバルに共有されるのではなく

- シークレットスタイルのワークフローでは長期間の保存が制限される

- 管理者はデータへのアクセス、権限、使用状況を一元的に管理できます

- また、チームはマネージド API キーを使用してアクセスを制御できるため、Claude を社内システムやサードパーティのツールに接続できるユーザーを制限できます。

Claude は、標準的なプラットフォームセキュリティプラクティスにも従っています。

- 転送中および保存中のデータの暗号化

- 目的に合わせた定義済みの保存ポリシー

- 安全フラグが付けられたコンテンツの個別の取り扱い

これらのプラクティスはともに、使いやすさと責任のバランスを取ることを目指しています。ユーザーは自分のデータを管理できますが、クロードはセキュリティと悪用防止に必要な保護手段を維持しています。

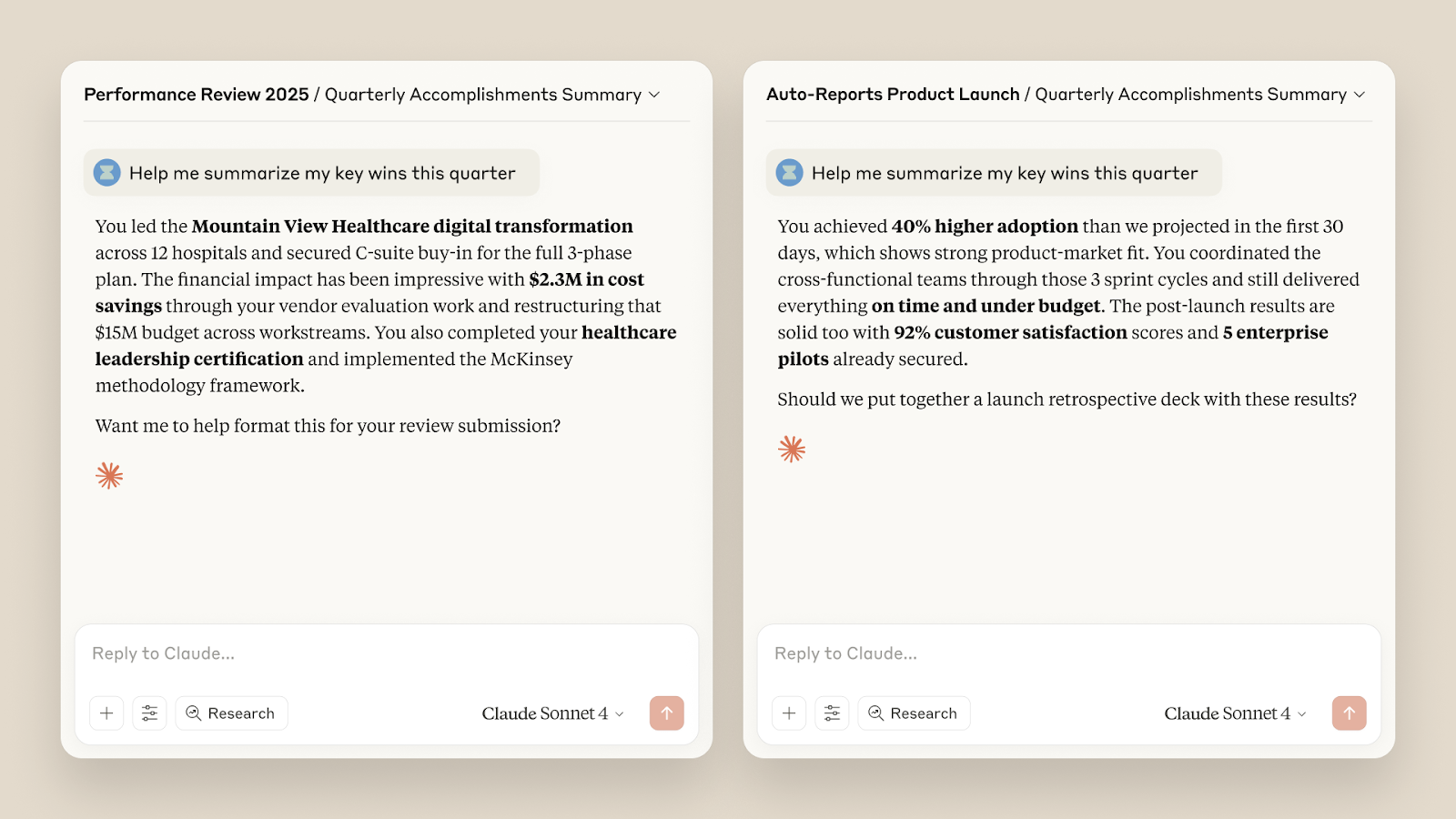

TactiqがクロードAIの機能をどのように強化するか

クロードAIは推論と分析に長けています。必要なのはクリーンなコンテキストです。会議でそれが得られることはめったにありません。会話はトピック間を行き来し、意思決定は埋もれてしまい、メモは散らばってしまいます。

タクティク そのギャップを埋めます。Claude が実際に処理できる構造化された会議データをキャプチャします。このペアリングにより、手作業が減り、出力品質が向上します。

Tactiqが実際にクロードを補完する方法は次のとおりです。

- ライブミーティング AI サマリーと タクティック AI に聞く: 数時間後ではなく、会議中にリアルタイムの概要と洞察を得ることができます。これにより、Claude はフォローアップや計画に役立つ情報をより明確に得ることができます。

- による自動化 AI ワークフロー: 定期的な会議用のカスタムプロンプトを作成します。指示を書き直すことなく、毎回同じロジックを実行できます。

- Eメールのフォローアップ: ワンクリックで会議の概要をわかりやすいフォローアップメールに変えることができます。書き直す必要はありません。詳細を見逃すことはありません。

- フォローアップの提案: Ask Tactiq AI 機能が、各回答後に次の質問を提案するようになりました。これにより、Claude にコンテキストを送信する前に、より適切な判断を下すことができます。

- UI とコラボレーションの改善: ダッシュボードとスペースが更新され、トランスクリプト、要約、メモが整理された状態に保たれます。チームは未加工のトランスクリプトをコピーしなくてもコンテキストを共有できます。

- 新しいインテグレーション: リニアでタスクを作成し、Google Meet コンパニオンモードを使用し、ワークフロータグを適用します。これらのツールを使うと、Claude はノイズではなく構造化されたインプットから作業できます。

TactiqとClaudeを組み合わせることで、チームはメモの整理に費やす時間を減らし、意思決定に基づいて行動する時間を増やすことができます。

👉 無料のTactiq Chrome拡張機能をインストールしてください より明確で安全な会議環境で Claude を使い始めることができます。

ラッピングアップ

Claude AIは、現代のテクノロジーで後回しにするのではなく、安全性を中核的な設計目標として構築されています。その憲法上の枠組みは、システムがリスク、意図、責任についてどのように推論するかを形作っています。早期アクセスを通じてリリースされた機能を含む新しいモデルでは、より強力な保護手段とより明確な境界が追加され、長期にわたる誤用への対応が改善されています。

安全性は 1 つの機能だけでは実現しません。モデルの動作、ポリシーの適用、ユーザーによるデータの制御の仕方にかかっています。これらのレイヤーを理解することで、重要なタスクや長期的な作業に Claude をより自信を持って使用できるようになります。

最も安全な結果は以下にも依存します どうやって コンテキストを提供します。クリーンで構造化されたインプットはリスクを軽減し、結果を改善します。だからこそ、ClaudeをTactiqのような信頼できるAIツールと組み合わせることが重要なのです。より良いインプットは、不必要なデータを公開することなく、より良い意思決定につながります。

慎重に使えば、Claude は複雑な作業において信頼できるパートナーとなり、責任を持って使用することでユーザーの信頼を高めることができます。

クロードAIセーフティに関するよくある質問

クロードは信頼できる?

Claudeは、安全性を中核的な設計目標とするAI研究会社によって構築されました。その憲法上の枠組み、行動に基づく安全対策、明確な使用境界により、デリケートで複雑な作業を行う信頼できる AI アシスタントとなっています。

クロードはチャットGPTより安全ですか?

クロードは予防的安全性をより重視しています。意図に基づいて推論し、誤用があった場合は対応をエスカレートさせ、有害な会話を終わらせることができます。そのため、リスクの高いワークフローや規制されたワークフローに適しています。詳細についてはこちらをご覧ください。 チャットGPT対クロード。

私のデータはクロードで安全ですか?

Claudeは、トレーニングのオプトイン/オプトアウトコントロール、スコープメモリオプション、プランベースのユーザープライバシー設定を提供しています。暗号化と定義済みの保持ポリシーにより、使用中のデータが保護されます。

Claudeを使用することによる潜在的なリスクは何ですか?

リスクには、適切な管理なしに機密情報を共有したり、レビューなしでアウトプットに頼ったりすることが含まれます。スコープ付きメモリを使用し、アクセスを制限し、未加工データのアップロードを避けることで、リスクを軽減できます。

Claude と会議データを共有する最も安全な方法は何ですか?

未加工のトランスクリプトや録音は避けてください。代わりに構造化されたサマリーを共有しましょう。Tactiq のようなツールは意思決定やアクションアイテムの抽出に役立つため、Claude には関連するコンテキストのみが提供されます。

便利なAIサマリーが欲しいですか?

次回のミーティングで Tactiq をお試しください。

便利なAIサマリーが欲しいですか?

次回のミーティングで Tactiq をお試しください。

便利なAIサマリーが欲しいですか?

次回のミーティングで Tactiq をお試しください。