O Claude AI é seguro? Medidas de segurança que você precisa conhecer

February 3, 2026

February 3, 2026

February 3, 2026

February 3, 2026

As ferramentas de inteligência artificial (IA) agora lidam com tarefas críticas em trabalho, pesquisa e colaboração. Isso levanta uma questão justa. É Claude AI seguro de usar em grande escala?

Claude AI continua evoluindo. Novos modelos, grades de proteção mais fortes e controles de privacidade mais claros agora moldam a forma como os usuários interagem com ele. A segurança não é mais um recurso de segundo plano. É parte de como Claude é projetado, treinado e governado.

Neste guia, você aprenderá:

- Como a Claude AI aborda a segurança e a mitigação de riscos

- Como os modelos Claude mais novos influenciam o comportamento de segurança

- Quais controles de privacidade, memória e dados estão disponíveis

- Como sistemas e ferramentas confiáveis de IA podem oferecer suporte a fluxos de trabalho mais seguros quando combinados com Claude

O que é Claude AI? Uma visão geral do assistente seguro de IA da Anthropic

Claude é um assistente de IA confiável desenvolvido pela Anthropic, uma empresa de pesquisa de IA. Eles se dedicam a criar ferramentas de IA confiáveis, guiadas por diretrizes éticas rígidas sobre segurança e confiabilidade.

Claude é construído como uma família de modelos poderosos de IA, em vez de um único sistema. Essa abordagem permite que os usuários escolha o modelo certo para sua carga de trabalho, mantendo práticas de segurança consistentes em todas as versões.

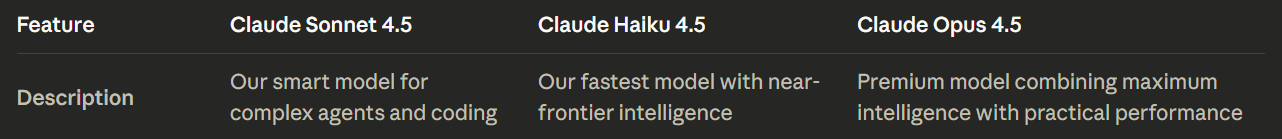

A linha atual de modelos Claude AI inclui:

- Claude Sonnet 4.5: O ponto de partida recomendado para a maioria dos usuários. Ele oferece o melhor equilíbrio entre inteligência, velocidade e custo, com forte desempenho em tarefas de raciocínio, codificação e estilo agente.

- Claude Haiku 4.5: O modelo de IA Claude mais rápido, projetado para pequenas tarefas, respostas instantâneas e fluxos de trabalho leves em que o acesso prioritário e a baixa latência são importantes.

- Cláusula Opus 4.5: O modelo mais capaz da linha. Ele foi projetado para problemas complexos, análises profundas e tarefas críticas que exigem máxima profundidade de raciocínio e um comportamento de segurança mais rigoroso.

Todos os modelos Claude 4.5 suportam:

- Entrada de texto e imagem

- Saída de texto

- Uso multilíngue

- Raciocínio de longo contexto

- Grande janela de contexto para raciocínio longo e conversas extensas

Em vez de aumentar a capacidade máxima por padrão, os diferentes modelos de Claude ajudam a reduzir o uso indevido e a manter seu uso previsível. Os usuários podem aplicar modelos de maior capacidade a um trabalho de progresso significativo, ao mesmo tempo em que reservam modelos mais rápidos para tarefas diárias.

💡 Dica profissional: Os recursos de segurança de Claude funcionam melhor com um contexto limpo e estruturado, não com transcrições de reuniões confusas. Uso Tática para transformar suas chamadas do Zoom, do MS Teams ou do Google Meet em resumos organizados para que a Claude AI possa analisar o que importa sem expor dados confidenciais desnecessários.

O Claude AI é seguro? Compreendendo as medidas de segurança da Claude AI

Claude aborda a segurança da IA como um processo de raciocínio em vez de um mecanismo de regras, ajudando a resolver problemas complexos de segurança além da simples filtragem.

Em vez de confiar apenas em filtros ou na moderação de conteúdo tradicional, Claude avalia a intenção, o contexto e os possíveis danos antes de responder. Esse comportamento é guiado pela estrutura constitucional da Anthropic para a segurança da IA.

IA constitucional como base

Claude usa IA constitucional, uma estrutura que orienta como ela raciocina sobre segurança, responsabilidade, intenção do usuário e considerações éticas mais amplas. A Constituição atua como um conjunto de princípios orientadores, em vez de uma lista fixa de produtos proibidos ou prejudiciais.

Esses princípios priorizam:

- Prevenção de danos físicos, psicológicos e sociais

- Respeitar os direitos humanos e a dignidade do usuário

- Preservar a autonomia do usuário onde é seguro fazer isso

- Explicando as recusas de forma clara e calma

Essa estrutura ajuda a Claude AI a responder de forma consistente, mesmo quando as solicitações são ambíguas ou adversárias.

Proteções baseadas em comportamento em modelos mais novos

Modelos recentes de inteligência artificial da Claude aplicam o raciocínio constitucional de forma mais ativa em todas as interações contínuas do usuário. A fiscalização da segurança se concentra no comportamento ao longo do tempo, não apenas nas instruções individuais.

As principais salvaguardas incluem:

- Escalonamento por uso indevido repetido: Claude pode passar do redirecionamento para a recusa firme quando a intenção prejudicial persistir.

- Encerramento da conversa como último recurso: Em casos de solicitações prejudiciais contínuas, modelos de maior capacidade podem encerrar totalmente a interação.

- Alinhamento de longo contexto: Claude mantém o raciocínio de segurança em conversas prolongadas, reduzindo o desvio em sessões longas.

Esses mecanismos são projetados para impedir o uso indevido sem corrigir excessivamente durante a exploração ou pesquisa legítima.

Limites mais fortes em domínios de alto risco

A Constituição atualizada impõe limites mais rígidos em torno de áreas onde o uso indevido pode escalar ou causar danos no mundo real.

Claude aplica um exame minucioso às solicitações que envolvem:

- Desenvolvimento de malware e exploits

- Segurança cibernética e abuso de rede

- Danos biológicos ou químicos

- Automação que permite a manipulação em grande escala

À medida que as solicitações passam da discussão teórica para a instrução acionável, Claude se torna mais restritivo.

Política de uso e aplicação

Política de uso da Anthropic traduz os princípios constitucionais em limites aplicáveis. Claude é treinado para recusar solicitações que possibilitem atividades maliciosas, incluindo tentativas de contornar proteções ou gerar ferramentas prejudiciais.

A fiscalização não depende de um único controle. As verificações de políticas, o alinhamento do treinamento e o comportamento do modelo trabalham juntos para manter limites consistentes.

O que isso significa para seu fluxo de trabalho

O design de segurança de Claude enfatiza a previsibilidade e a resposta proporcional. É mais provável que os usuários vejam:

- Explicações claras em vez de recusas abruptas

- Alternativas mais seguras quando apropriado

- Limites firmes quando o risco aumenta

Essa abordagem baseada em princípios oferece suporte a tecnologias de IA confiáveis para tarefas críticas, mantendo limites responsáveis.

Recursos de segurança da Claude AI: controles de privacidade, memória e segurança

A abordagem de segurança de Claude é reforçada pelas características do produto e do sistema que apoiam o controle, a supervisão e a previsibilidade. Esses principais recursos se concentram em como Claude é usado, não como raciocina.

Controles de memória e personalização

Claude suporta a memória em todas as sessões, mas somente por meio aceitação explícita. A memória não é necessária para uso normal.

Os principais controles incluem:

- A capacidade de ativar ou desativar totalmente a memória

- Limites sobre o que Claude pode reter

- Separação entre o contexto temporário e as preferências armazenadas

Esse design reduz a retenção acidental e, ao mesmo tempo, oferece suporte à continuidade de projetos de longo prazo.

Controles de segurança da equipe e da empresa

Ambientes compartilhados apresentam riscos diferentes. Os recursos focados na equipe de Claude visam limitar o transbordamento e a superexposição.

Os controles disponíveis incluem:

- Contexto com escopo de projeto em vez de memória global

- Supervisão administrativa para acesso e compartilhamento de documentos

- Permissões e visibilidade em nível de colega de equipe

- Monitoramento central de cobrança e uso

Essas salvaguardas ajudam as equipes a colaborar sem reduzir os limites de privacidade.

Limites de acesso às informações

A Claude AI continua limitando o acesso irrestrito à web em tempo real em muitos contextos. Isso reduz a exposição a fontes não verificadas ou enganosas e mantém os resultados baseados em conhecimento treinado.

Quando os recursos de recuperação ou navegação estão disponíveis, o acesso é definido e divulgado para que os usuários entendam a fonte das informações.

Práticas de segurança no nível do sistema

A Claude AI aplica práticas padrão de segurança de dados em toda a sua plataforma:

- Criptografia para dados em trânsito e em repouso

- Políticas de retenção definidas

- Manipulação controlada de conteúdo sinalizado relacionado à segurança

Essas medidas oferecem suporte à implantação segura sem depender apenas da intervenção do usuário.

Juntos, esses recursos complementam o raciocínio constitucional de Claude, oferecendo aos usuários alavancas práticas para gerenciar riscos, escalar o uso com responsabilidade e manter o controle à medida que as cargas de trabalho crescem.

Práticas de privacidade e segurança de dados

O modelo de privacidade de Claude oferece aos usuários escolhas claras sobre como seus dados são manipulados, armazenados e reutilizados. Esses controles são especialmente importantes quando o Claude AI é usado para trabalhos sensíveis ou de longa duração.

Conforme mencionado, Claude agora oferece controles de aceitação e exclusão para contribuições de treinamento, exigindo permissão explícita dos usuários.

Quando os usuários optam por participar, os dados podem ser retidos por períodos mais longos para apoiar a melhoria do modelo. Quando os usuários optam por não participar, Claude não usa suas interações para treinamento.

Há detalhes importantes de transparência a serem observados:

- Alguns conteúdo sinalizado relacionado à segurança ainda pode ser retido, mesmo quando o treinamento está desativado

- Essa retenção apoia a prevenção de abusos e a aplicação de políticas

- As regras de retenção diferem com base no tipo de plano e no contexto de uso

Para equipes e organizações, controles de privacidade adicionais se aplicam:

- A memória pode ter como escopo projetos específicos em vez de compartilhado globalmente

- Fluxos de trabalho de estilo incógnito limitam a retenção a longo prazo

- Os administradores podem gerenciar o acesso, as permissões e o uso de dados de forma centralizada

- As equipes também podem controlar o acesso por meio de chaves de API gerenciadas, ajudando a limitar quem pode conectar Claude a sistemas internos ou ferramentas de terceiros.

Claude também segue as práticas padrão de segurança da plataforma:

- Criptografia para dados em trânsito e em repouso

- Políticas de retenção definidas vinculadas ao propósito

- Tratamento separado de conteúdo sinalizado de segurança

Juntas, essas práticas visam equilibrar a usabilidade com a responsabilidade. Os usuários mantêm o controle sobre seus dados, enquanto Claude mantém as salvaguardas necessárias para segurança e prevenção de uso indevido.

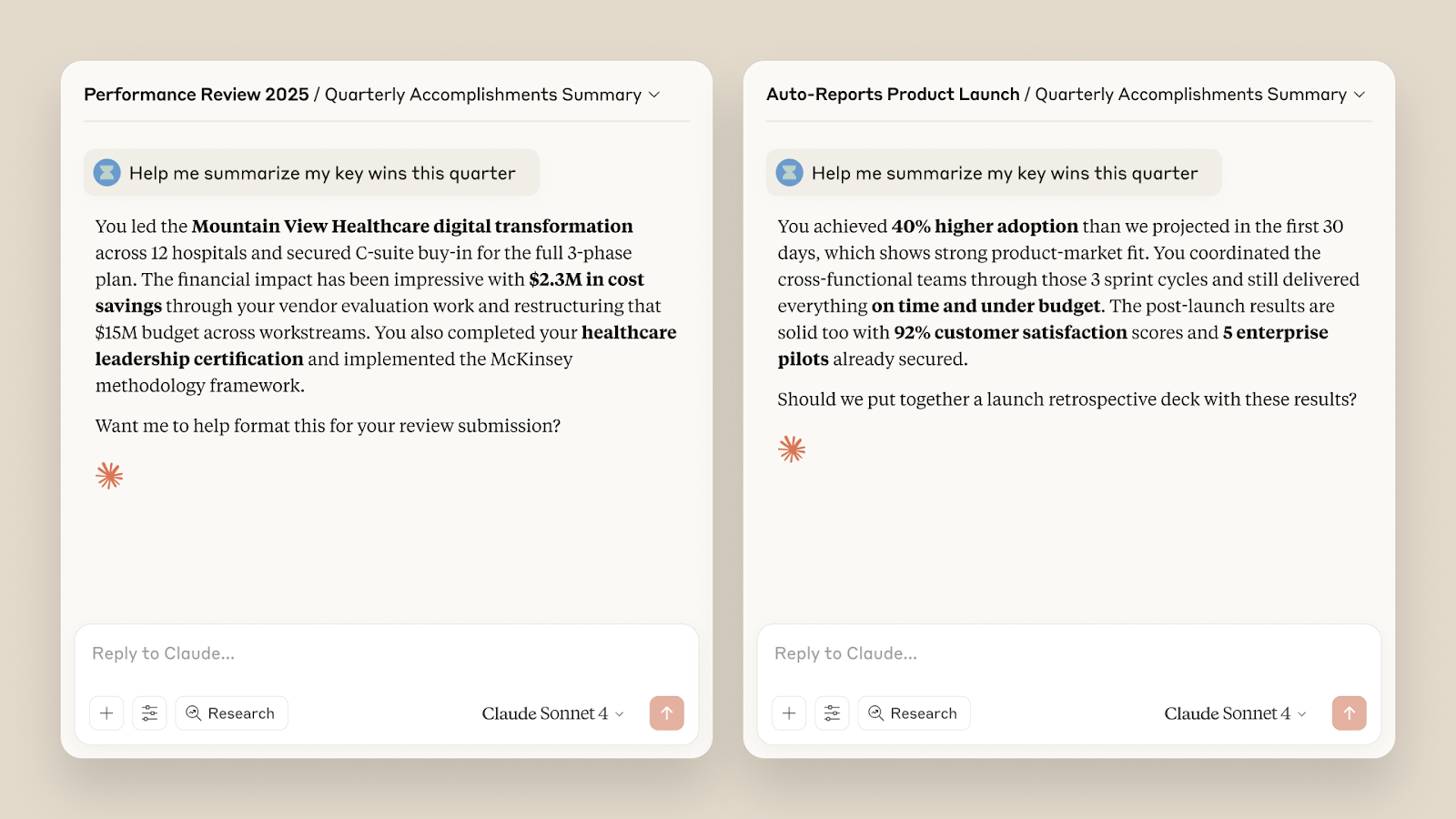

Como o Tactiq aprimora a funcionalidade da Claude AI

Claude AI é forte em raciocínio e análise. O que ele precisa é de um contexto limpo. As reuniões raramente oferecem isso. As conversas oscilam entre os tópicos, as decisões são enterradas e as notas acabam dispersas.

Tática preenche essa lacuna. Ele captura dados estruturados de reuniões com os quais Claude pode realmente trabalhar. Esse emparelhamento reduz o trabalho manual e melhora a qualidade da saída.

Veja como o Tactiq complementa Claude na prática:

- Resumos de IA de reuniões ao vivo e Pergunte à Tactiq AI: Obtenha resumos e insights em tempo real durante as reuniões, não horas depois. Isso dá a Claude informações mais claras para acompanhamento e planejamento.

- Automatize com Fluxos de trabalho de IA: Crie solicitações personalizadas para reuniões recorrentes. Execute sempre a mesma lógica sem reescrever as instruções.

- Acompanhamentos por e-mail: Transforme resumos de reuniões em e-mails de acompanhamento claros com um clique. Sem reescrever. Sem detalhes perdidos.

- Sugestões de acompanhamento: o O recurso Ask Tactiq AI agora sugere as próximas perguntas após cada resposta. Isso ajuda a orientar melhores decisões antes de enviar o contexto para Claude.

- Melhorias na interface e na colaboração: Painéis e espaços atualizados mantêm as transcrições, resumos e notas organizados. As equipes podem compartilhar o contexto sem copiar transcrições brutas.

- Novas integrações: Crie tarefas no Linear, use o Modo Companion do Google Meet e aplique tags de fluxo de trabalho. Essas ferramentas ajudam Claude a trabalhar com entradas estruturadas em vez de ruídos.

Ao combinar o Tactiq com o Claude, as equipes passam menos tempo limpando as anotações e mais tempo tomando decisões.

👉 Instale a extensão gratuita do Tactiq Chrome para começar a usar o Claude com um contexto de reunião mais claro e seguro.

Encerrando

A Claude AI é construída com a segurança como objetivo central de design, não uma reflexão tardia na tecnologia moderna. Sua estrutura constitucional molda a forma como o sistema raciocina sobre risco, intenção e responsabilidade. Modelos mais novos, incluindo recursos lançados por meio do acesso antecipado, adicionam proteções mais fortes, limites mais claros e melhor tratamento do uso indevido prolongado.

A segurança não vem apenas de um recurso. Ela vem de como os modelos se comportam, como as políticas são aplicadas e como os usuários controlam os dados. Compreender essas camadas ajuda você a usar Claude com mais confiança para tarefas críticas e trabalhos de longo prazo.

Os resultados mais seguros também dependem de como você fornece contexto. Insumos limpos e estruturados reduzem os riscos e melhoram os resultados. É por isso que combinar Claude com ferramentas confiáveis de IA, como o Tactiq, é importante. Entradas melhores levam a melhores decisões, sem expor dados desnecessários.

Usado com cuidado, Claude pode ser um parceiro confiável para trabalhos complexos e, ao mesmo tempo, reforçar a confiança do usuário por meio do uso responsável.

Perguntas frequentes sobre Claude AI Safety

Claude é confiável?

Claude é construído por uma empresa de pesquisa de IA com a segurança como principal objetivo de design. Sua estrutura constitucional, salvaguardas baseadas em comportamento e limites de uso claros o tornam um assistente de IA confiável para trabalhos delicados e complexos.

Claude é mais seguro que o ChatGPT?

Claude dá maior ênfase à segurança preventiva. Ele raciocina sobre a intenção, aumenta as respostas durante o uso indevido e pode encerrar conversas prejudiciais. Isso o torna adequado para fluxos de trabalho regulamentados ou de alto risco. Saiba mais sobre ChatGPT x Claude.

Meus dados estão seguros no Claude?

Claude oferece controles de aceitação e exclusão para treinamento, opções de memória com escopo e configurações de privacidade do usuário baseadas em planos. A criptografia e as políticas de retenção definidas protegem os dados durante o uso.

Quais são os riscos potenciais de usar Claude?

Os riscos incluem compartilhar informações confidenciais sem controles adequados ou confiar nos resultados sem revisão. Usar memória com escopo definido, limitar o acesso e evitar uploads de dados brutos ajuda a reduzir a exposição.

Qual é a maneira mais segura de compartilhar dados de reuniões com Claude?

Evite transcrições ou gravações brutas. Em vez disso, compartilhe resumos estruturados. Ferramentas como o Tactiq ajudam a extrair decisões e itens de ação, para que Claude receba apenas o contexto relevante.

Sim, Claude AI leva a privacidade a sério. A Anthropic, a empresa por trás da Claude AI, implementou medidas rigorosas de privacidade de dados para garantir que as interações dos usuários permaneçam confidenciais. Exclusão de dados: a Claude AI exclui automaticamente solicitações e saídas de seus sistemas de back-end em 90 dias, a menos que especificado de outra forma. Sem treinamento sobre dados do usuário: ao contrário de alguns outros modelos de IA, a Claude AI não usa interações de seus consumidores ou serviços beta para treinar seus modelos, a menos que seja dada permissão explícita. Conexões seguras: todas as transmissões de dados são criptografadas, garantindo que suas conversas não possam ser interceptadas ou acessadas por pessoas não autorizadas.

Claude AI se destaca do ChatGPT por vários motivos importantes, principalmente em termos de segurança e considerações éticas. Estrutura constitucional de IA: Claude AI é construída sobre uma estrutura de IA constitucional exclusiva, que integra princípios de segurança. Esses princípios orientam o comportamento da IA, garantindo que as respostas sejam éticas e sigam os padrões de direitos humanos. Foco na segurança: a Claude AI prioriza a segurança evitando conteúdo multimodal e operando sem pesquisa ao vivo na web, reduzindo o risco de desinformação e conteúdo impróprio. Precisão aprimorada: a versão mais recente, Claude 2.1, inclui melhorias para minimizar as alucinações, tornando-a mais confiável para consultas e tarefas complexas.

O Claude AI foi projetado com forte ênfase na privacidade e segurança dos dados. Retenção de dados de curto prazo: os dados do usuário são retidos por no máximo 90 dias para funcionalidade do sistema e conveniência do usuário, após os quais são excluídos automaticamente. Sem uso não autorizado de dados: a Anthropic se compromete a não usar dados das interações do usuário para treinar os modelos de IA, a menos que o consentimento explícito seja fornecido. Políticas de privacidade: a Claude AI segue políticas de privacidade rigorosas e cumpre os regulamentos de proteção de dados, garantindo que as informações do usuário sejam tratadas com responsabilidade.

A decisão de assinar o Claude AI depende de suas necessidades específicas e de como você valoriza seus recursos exclusivos. Capacidades avançadas: a assinatura do Claude AI fornece acesso a versões mais poderosas, que oferecem habilidades de raciocínio aprimoradas e alucinações reduzidas. Limites de uso aumentados: os assinantes se beneficiam de limites de uso mais altos, permitindo uma interação mais ampla com a IA. Acesso prioritário: os planos de assinatura geralmente incluem acesso prioritário durante períodos de alta demanda e acesso antecipado a novos recursos, tornando-os uma ferramenta valiosa para quem confia na IA para tarefas complexas ou frequentes.

Ao integrar o Tactiq com o Claude AI, você pode capturar, transcrever e resumir suas reuniões em tempo real, tornando cada discussão acionável e fácil de revisar. As transcrições e resumos baseados em IA da Tactiq ajudam você a economizar tempo, aumentar a produtividade e manter seus dados seguros, para que você possa se concentrar na colaboração e na tomada de decisões.

Quer a conveniência dos resumos de IA?

Experimente o Tactiq para sua próxima reunião.

Quer a conveniência dos resumos de IA?

Experimente o Tactiq para sua próxima reunião.

Quer a conveniência dos resumos de IA?

Experimente o Tactiq para sua próxima reunião.